Ciencia y Tecnología

La nevada de Kamchatka generada por IA simboliza algo preocupante: ya no podemos fiarnos de ninguna imagen en internet

En 2012 el huracán Sandy asoló el Mar Caribe y llegó a alcanzar la costa de Nueva York. Allí dejó inundaciones, cortes del suministro eléctrico y fotos espectaculares. De todas ellas hubo una especialmente asombrosa que se convirtió en viral, pero había un problema: era falsa. No fue la única que se coló en redes.

Aquella imagen fue tan solo un ejemplo más de lo que antes y después hemos ido viendo: los grandes fenómenos y sucesos acaban generando riadas de contenidos, algunos de los cuales no son reales.

Hay muchas razones por las que la gente aprovecha estos momentos para difundir imágenes falsas, pero al menos antes lograr imágenes y vídeos creíbles era costoso. Solo los usuarios avanzados de aplicaciones como Photoshop o Final Cut / Premiere podían lograr resultados convincentes, pero la IA, como sabemos, ha cambiado todo eso.

Llevamos alertando de este problema desde hace tiempo: distinguir entre lo real y lo generado por IA es cada vez más difícil. y estos días hemos tenido el último gran ejemplo de esta tendencia.

Anatomía de un deepfake

En la península de Kamchatka, en el extremo oriental de Rusia, se ha vivido un temporal de nieve histórico. El peor en décadas, según los registros, con niveles de nieve que superan los dos metros en diversas áreas, según Xinhua.

Petropávlovsk-Kamchatski, centro administrativo, industrial, y científico del Krai de Kamchatka, ha sufrido especialmente esas consecuencias, y vecinos de la región han difundido en redes imágenes del que ya ha sido bautizado como el “apocalipsis de la nieve”. Esas imágenes difundidas en medios de noticias y redes sociales y que eran reales —a menudo más “mundanas” y mucho menos espectaculares— contrastan con otras que teóricamente también mostraban el estado de varios puntos de la región pero que en realidad están generadas con IA.

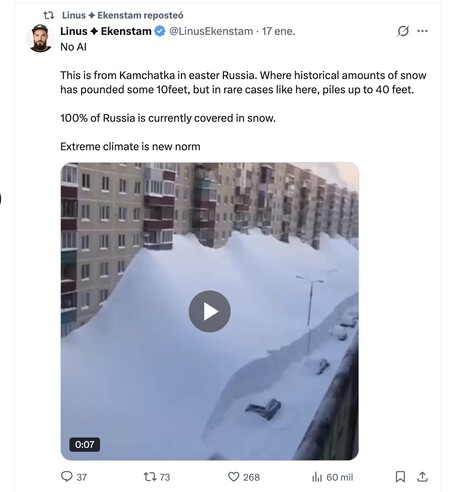

Ese vídeo, por ejemplo, era compartido hace unos días por Linus Ekenstam, influencer que a menudo comparte noticias y reflexiones sobre IA. Él republicaba ese vídeo y afirmaba que era real, pero pronto varios usuarios indicaban que en realidad el vídeo estaba creado por IA.

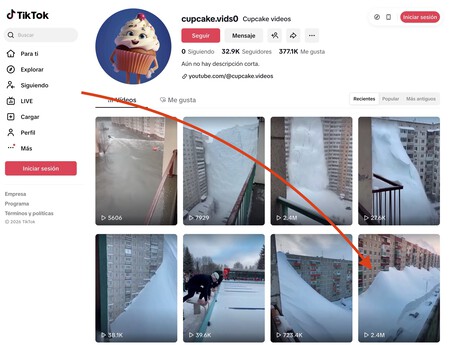

Ekenstam argumentaba que el teórico error de la IA que señalaba en el usuario no era tal, y que en donde él vive hay postes cerca de las farolas. Trataba por tanto de defender que para él el vídeo era real, pero otros apuntaban a que no lo era. La prueba definitiva: un usuario enlazaba al teórico vídeo original, que al parecer se originó en una cuenta de TikTok dedicada precisamente a difundir contenidos generados por IA que parecen reales.

Lo crucial de ese vídeo falso es que es espectacular, pero no exageradamente espectacular. Es, hasta cierto punto, creíble, y cuando la imagen y el propio movimiento de la cámara es tan convincente, cuesta pensar que “quizas esté generado por IA”.

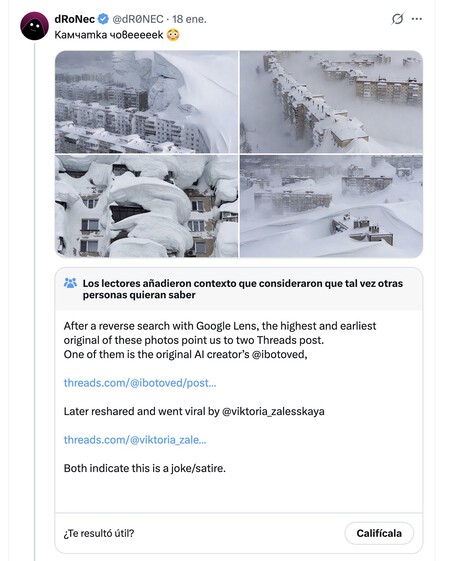

Con este temporal de nieve vivido en Kamchatka se han compartido en redes imágenes insólitas, mucho más propias de una película distópica de Hollywood que de un fenómeno natural real. A priori las imágenes pueden resultar hasta coherentes, pero un examen más detallado —y sobre todo, más crítico—, facilita que nos demos cuenta de que quizás esas imágenes no sean tan reales como parecen.

De hecho, las imágenes más llamativas compartidas en redes sociales y que acumulan miles de retuits y de likes en X, por ejemplo, contrastan con las que se publican en medios tradicionales, que suelen ser como decíamos mucho menos llamativas y mucho más mundanas.

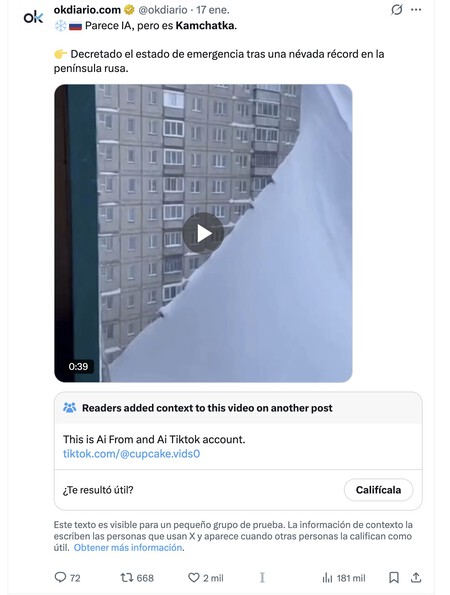

Medios españoles como OndaCero u OKDiario han publicado en sus medios digitales o en sus cuentas en redes sociales algunas imágenes y vídeos generados por IA sin darse cuenta de que efectivamente esos vídeos tenían su origen en la citada cuenta de TikTok que ha logrado que se difundieran como la pólvora.

Los debates sobre la posibilidad de que ciertas imágenes pudieran ser reales han sido frecuentes por ejemplo en Reddit, donde los usuarios compartían por ejemplo una asombrosa captura que analizada en detalle parecía generada por IA.

La avalancha de “periodismo ciudadano”, que puede ser bienintencionada y muy importante en ocasiones, contrasta aquí con el papel de los medios, que tienen la responsabilidad enorme a la hora de actuar como fuentes de información de confianza.

Hasta ellos (y nosotros) pueden caer en la trampa, y aquí una vez más lo mejor es comenzar a desconfiar de lo que vemos en nuestras pantallas, porque puede ser un contenido falso. Los vídeos aparecidos en algunos medios como Sky News o en La Vanguardia se combinan con otros que a (al menos, a priori) parecen reales, pero que a estas alturas también exigen un examen riguroso.

Nuestro cerebro nos traiciona y la tecnología lo sabe

Hay varios fenómenos psicológicos y sesgos cognitivos bien estudiados que explican por qué creíamos en el pasado en las fake news y ahora nos vuelve a pasar lo mismo con los deepfakes.

Da igual que sepamos (o al menos sospechemos) racionalmente que esas imágenes y vídeos sean falsos: la tecnología y sobre todo la IA precisamente explotan esos sesgos. Entre ellos destacan los siguientes:

- Sesgo de confirmación: creemos lo que encaja con lo que ya creemos. Nuestro cerebro no buscan tanto la verdad como la coherencia interna, así que si una noticia refuerza nuestra ideología, bajamos el nivel de las potenciales críticas, pero si la contradice, la analizamos con lupa o directamente la descartamos. Aquí el problema es que la IA puede generar contenidos hechos a medida y ajustados a cada narrativa.

- Efecto de verdad ilusoria: aquí sucede que “si lo he visto muchas veces, será verdad”. La repetición aumenta la sensación de veracidad, no la veracidad real, y es algo que por ejemplo aprovechan al máximo las redes sociales, máquinas de repetir bulos. De nuevo la IA facilita la producción masiva de la misma mentira con variaciones mínimas.

- Creemos lo que vemos: es lo que algunos llaman realismo perceptivo. Confiamos demasiado en lo visual, y de ahí el célebre dicho de “una imagen vale más que mil palabras”. Las imágenes se procesan mucho más rápido que el exto, y el pensamiento crítico llega después de la reacción emocional, como bien argumentó Daniel Kanheman en su célebre ‘Pensar rápido, pensar despacio’.

- Carga cognitiva: relacionado con lo anterior, pensar de forma crítica cansa, y eso hace que cuando estamos cansados, distraídos o con prisa usemos atajos mentales. El célebre y preocupante doomscrolling aprovecha muy bien esa trampa, y tanto las fake news como los deepfakes están diseñados para ser fáciles de creer, no para ser analizados.

Hay más, por supuesto. La IA genera ya resultados convincentes pero además —sobre todo en texto— su seguridad a la hora de comunicarlos y expresarlos activa un sesgo de autoridad. Es como si pareciera más fiable que si nos lo dijera un experto humano que por lo que sea no tiene tanta facilidad para comunicar sus conocimientos con destreza.

Los contenidos generados con IA también aprovechan esos grandes fenómenos y sucesos que maximizan el impacto emocional, y además está el hecho de que cuando mucha gente lo comparte es porque “debe ser cierto” y porque solemos creer que son los demas los que caen en estos engaños, no nosotros.

Como decía aquel, tengan cuidado ahí fuera.

–

La noticia

La nevada de Kamchatka generada por IA simboliza algo preocupante: ya no podemos fiarnos de ninguna imagen en internet

fue publicada originalmente en

Xataka

por

Javier Pastor

.

En 2012 el huracán Sandy asoló el Mar Caribe y llegó a alcanzar la costa de Nueva York. Allí dejó inundaciones, cortes del suministro eléctrico y fotos espectaculares. De todas ellas hubo una especialmente asombrosa que se convirtió en viral, pero había un problema: era falsa. No fue la única que se coló en redes.

Aquella imagen fue tan solo un ejemplo más de lo que antes y después hemos ido viendo: los grandes fenómenos y sucesos acaban generando riadas de contenidos, algunos de los cuales no son reales.

En Xataka

No sabríamos decirte si la imagen que encabeza este post es real o generada por IA: estamos en la era de la duda permanente

Hay muchas razones por las que la gente aprovecha estos momentos para difundir imágenes falsas, pero al menos antes lograr imágenes y vídeos creíbles era costoso. Solo los usuarios avanzados de aplicaciones como Photoshop o Final Cut / Premiere podían lograr resultados convincentes, pero la IA, como sabemos, ha cambiado todo eso.

Llevamos alertando de este problema desde hace tiempo: distinguir entre lo real y lo generado por IA es cada vez más difícil. y estos días hemos tenido el último gran ejemplo de esta tendencia.

Anatomía de un deepfakeEn la península de Kamchatka, en el extremo oriental de Rusia, se ha vivido un temporal de nieve histórico. El peor en décadas, según los registros, con niveles de nieve que superan los dos metros en diversas áreas, según Xinhua.

Petropávlovsk-Kamchatski, centro administrativo, industrial, y científico del Krai de Kamchatka, ha sufrido especialmente esas consecuencias, y vecinos de la región han difundido en redes imágenes del que ya ha sido bautizado como el “apocalipsis de la nieve”. Esas imágenes difundidas en medios de noticias y redes sociales y que eran reales —a menudo más “mundanas” y mucho menos espectaculares— contrastan con otras que teóricamente también mostraban el estado de varios puntos de la región pero que en realidad están generadas con IA.

Ese vídeo, por ejemplo, era compartido hace unos días por Linus Ekenstam, influencer que a menudo comparte noticias y reflexiones sobre IA. Él republicaba ese vídeo y afirmaba que era real, pero pronto varios usuarios indicaban que en realidad el vídeo estaba creado por IA.

Ekenstam argumentaba que el teórico error de la IA que señalaba en el usuario no era tal, y que en donde él vive hay postes cerca de las farolas. Trataba por tanto de defender que para él el vídeo era real, pero otros apuntaban a que no lo era. La prueba definitiva: un usuario enlazaba al teórico vídeo original, que al parecer se originó en una cuenta de TikTok dedicada precisamente a difundir contenidos generados por IA que parecen reales.

Lo crucial de ese vídeo falso es que es espectacular, pero no exageradamente espectacular. Es, hasta cierto punto, creíble, y cuando la imagen y el propio movimiento de la cámara es tan convincente, cuesta pensar que “quizas esté generado por IA”.

Con este temporal de nieve vivido en Kamchatka se han compartido en redes imágenes insólitas, mucho más propias de una película distópica de Hollywood que de un fenómeno natural real. A priori las imágenes pueden resultar hasta coherentes, pero un examen más detallado —y sobre todo, más crítico—, facilita que nos demos cuenta de que quizás esas imágenes no sean tan reales como parecen.

De hecho, las imágenes más llamativas compartidas en redes sociales y que acumulan miles de retuits y de likes en X, por ejemplo, contrastan con las que se publican en medios tradicionales, que suelen ser como decíamos mucho menos llamativas y mucho más mundanas.

Medios españoles como OndaCero u OKDiario han publicado en sus medios digitales o en sus cuentas en redes sociales algunas imágenes y vídeos generados por IA sin darse cuenta de que efectivamente esos vídeos tenían su origen en la citada cuenta de TikTok que ha logrado que se difundieran como la pólvora.

Los debates sobre la posibilidad de que ciertas imágenes pudieran ser reales han sido frecuentes por ejemplo en Reddit, donde los usuarios compartían por ejemplo una asombrosa captura que analizada en detalle parecía generada por IA.

La avalancha de “periodismo ciudadano”, que puede ser bienintencionada y muy importante en ocasiones, contrasta aquí con el papel de los medios, que tienen la responsabilidad enorme a la hora de actuar como fuentes de información de confianza.

Hasta ellos (y nosotros) pueden caer en la trampa, y aquí una vez más lo mejor es comenzar a desconfiar de lo que vemos en nuestras pantallas, porque puede ser un contenido falso. Los vídeos aparecidos en algunos medios como Sky News o en La Vanguardia se combinan con otros que a (al menos, a priori) parecen reales, pero que a estas alturas también exigen un examen riguroso.

Nuestro cerebro nos traiciona y la tecnología lo sabeHay varios fenómenos psicológicos y sesgos cognitivos bien estudiados que explican por qué creíamos en el pasado en las fake news y ahora nos vuelve a pasar lo mismo con los deepfakes.

Da igual que sepamos (o al menos sospechemos) racionalmente que esas imágenes y vídeos sean falsos: la tecnología y sobre todo la IA precisamente explotan esos sesgos. Entre ellos destacan los siguientes:

Sesgo de confirmación: creemos lo que encaja con lo que ya creemos. Nuestro cerebro no buscan tanto la verdad como la coherencia interna, así que si una noticia refuerza nuestra ideología, bajamos el nivel de las potenciales críticas, pero si la contradice, la analizamos con lupa o directamente la descartamos. Aquí el problema es que la IA puede generar contenidos hechos a medida y ajustados a cada narrativa. Efecto de verdad ilusoria: aquí sucede que “si lo he visto muchas veces, será verdad”. La repetición aumenta la sensación de veracidad, no la veracidad real, y es algo que por ejemplo aprovechan al máximo las redes sociales, máquinas de repetir bulos. De nuevo la IA facilita la producción masiva de la misma mentira con variaciones mínimas.Creemos lo que vemos: es lo que algunos llaman realismo perceptivo. Confiamos demasiado en lo visual, y de ahí el célebre dicho de “una imagen vale más que mil palabras”. Las imágenes se procesan mucho más rápido que el exto, y el pensamiento crítico llega después de la reacción emocional, como bien argumentó Daniel Kanheman en su célebre ‘Pensar rápido, pensar despacio’. Carga cognitiva: relacionado con lo anterior, pensar de forma crítica cansa, y eso hace que cuando estamos cansados, distraídos o con prisa usemos atajos mentales. El célebre y preocupante doomscrolling aprovecha muy bien esa trampa, y tanto las fake news como los deepfakes están diseñados para ser fáciles de creer, no para ser analizados.

Hay más, por supuesto. La IA genera ya resultados convincentes pero además —sobre todo en texto— su seguridad a la hora de comunicarlos y expresarlos activa un sesgo de autoridad. Es como si pareciera más fiable que si nos lo dijera un experto humano que por lo que sea no tiene tanta facilidad para comunicar sus conocimientos con destreza.

En Xataka

Internet busca sin cesar vídeos de gente atacada por tiburones y orcas. La clave está en el morbo… creado por IA

Los contenidos generados con IA también aprovechan esos grandes fenómenos y sucesos que maximizan el impacto emocional, y además está el hecho de que cuando mucha gente lo comparte es porque “debe ser cierto” y porque solemos creer que son los demas los que caen en estos engaños, no nosotros.

Como decía aquel, tengan cuidado ahí fuera.

En Xataka | Es imposible distinguir si este vídeo con los actores de ‘Stranger Things’ está hecho con IA o no. Eso es un problema

– La noticia

La nevada de Kamchatka generada por IA simboliza algo preocupante: ya no podemos fiarnos de ninguna imagen en internet

fue publicada originalmente en

Xataka

por

Javier Pastor

.