Ciencia y Tecnología

A la IA se le está quedando corta la energía de este mundo. Así que Nvidia ha apostado por servidores en el espacio

El apetito energético de los centros de datos no es ninguna novedad. Elon Musk vaticina una escasez de transformadores en dos años. Sam Altman cree que necesitaremos una revolución energética, como la fusión nuclear, para mantener el ritmo. El planeta no estaba preparado para tanta demanda de energía. Y por eso Nvidia está financiando una posible solución: desplegar los servidores fuera de la Tierra.

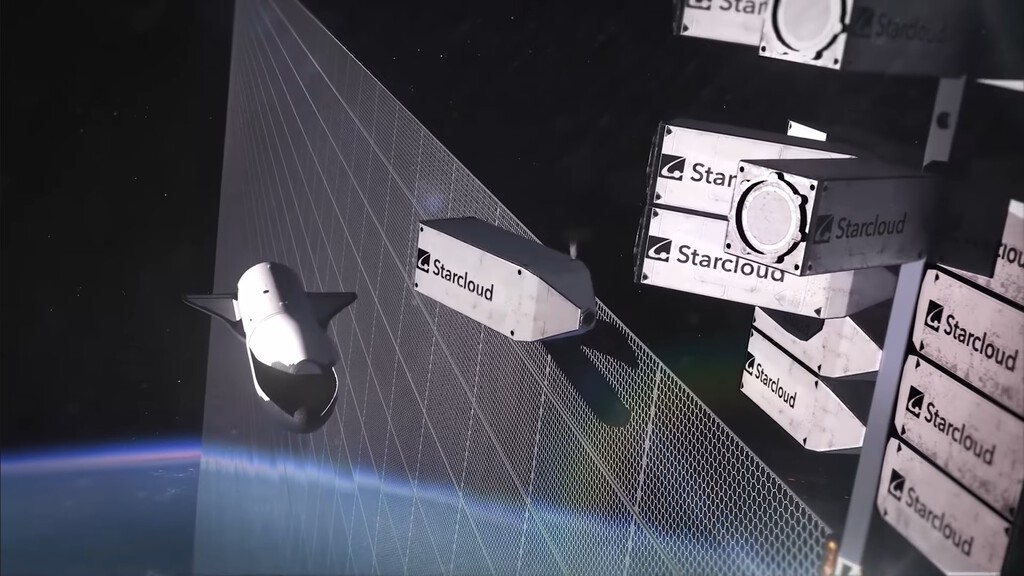

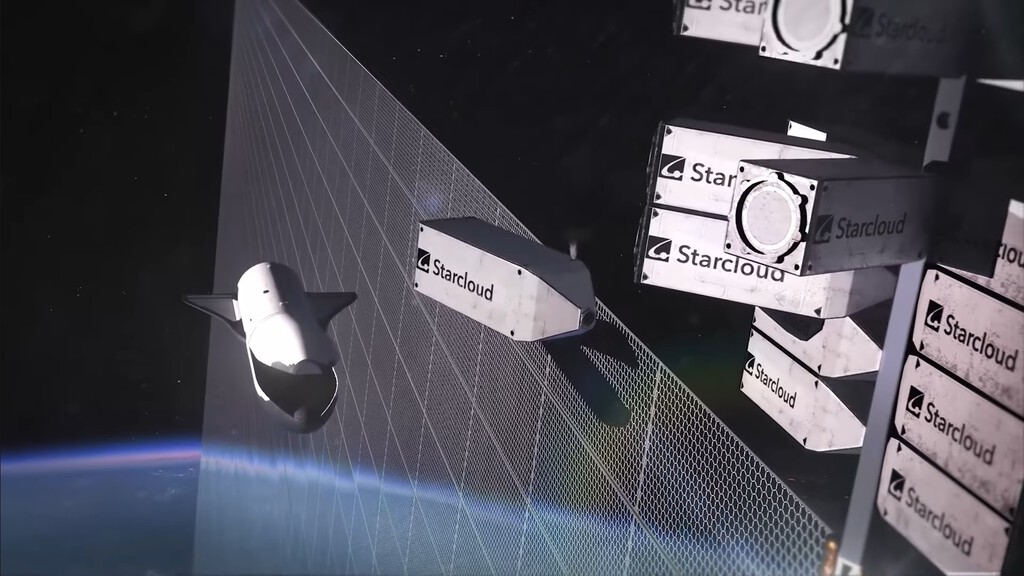

No es ciencia ficción. Es el modelo de negocio de varias startups que proponen construir los próximos hipercentros de datos en la órbita terrestre e incluso en la Luna. La idea, que hasta hace poco sonaba descabellada, está cobrando tracción impulsada principalmente por dos factores: la demanda insaciable de la IA y los lanzamientos a bajo coste que promete Starship.

Una de las empresas que lidera esta idea es Starcloud, respaldada por el programa NVIDIA Inception. Y va tan en serio que planea lanzar su primer satélite, el Starcloud-1, en noviembre. A bordo llevará la primera GPU para data centers lanzada al espacio: una NVIDIA H100.

Lo difícil vendrá después. Starcloud-1 es una unidad de prueba del tamaño de una nevera pequeña, pero el objetivo de la compañía es construir un monstruoso centro de datos orbital de cinco gigavatios. Sumando los paneles solares y el enorme radiador, mediría cuatro kilómetros de ancho. Su objetivo es el entrenamiento de grandes modelos de IA en órbita.

¿Por qué en el espacio? Como detallan en un extenso white paper, los modelos futuros como GPT-6 o Llama 5 podrían requerir clústeres de varios gigavatios, algo “simplemente imposible con la infraestructura energética actual” de la Tierra. En el espacio, no existe esa limitación.

Es más. Según los cálculos de Starcloud, los costes energéticos de los servidores son 10 veces menores en el espacio que en la Tierra. La propuesta de valor de los data centers espaciales se sostiene, precisamente sobre dos pilares que en la Tierra son un problema: la energía y la refrigeración.

Energía solar 24/7. En la Tierra, la energía solar es intermitente. Dependen del ciclo día/noche, el tiempo y la atmósfera, que atenúa la radiación. En el espacio, la cosa cambia. Al situar sus data centers en una órbita heliosíncrona de tipo “amanecer-anochecer”, los satélites siguen la línea que divide el día y la noche en la Tierra.

Con los paneles iluminados por el sol de forma casi continua, el sistema eleva su capacidad a más del 95%. “Energía renovable casi ilimitada y de bajo coste”, en palabras de Starcloud.

¿Y la refrigeración? ¿Cómo disiparían todo ese calor? Los data centers terrestres consumen millones de litros de agua dulce para enfriarse. En el espacio no hay agua, pero tienen algo mucho mejor: un disipador térmico infinito a -270°C.

El plan no es ventilar los servidores. El calor generado por las GPU (como la H100) se gestionará dentro de los módulos sellados mediante refrigeración líquida (directa al chip o por inmersión), como los sistemas de alto rendimiento en la Tierra. La diferencia es que ese líquido caliente no va a una torre de evaporación, sino que se bombea a unos paneles radiadores gigantescos.

Estos paneles simplemente irradian el calor residual al vacío del espacio en forma de radiación infrarroja. El white paper de Starcloud detalla los cálculos usando la ley de Stefan-Boltzmann, estimando que un radiador a 20°C puede disipar limpiamente más de 630 vatios por metro cuadrado. Sin usar una sola gota de agua.

No es oro todo lo que reluce en el espacio. El pilar que sostiene todo este concepto es el lanzamiento de cohetes reutilizables de gran capacidad, como el Starship de SpaceX. Los cálculos de Starcloud se basan en un coste a largo plazo de 30 dólares por kilo puesto en órbita. Pero Starship no está lista, y desde luego está lejos de lograr su capacidad de reutilización rápida y total. Si ese coste no se materializa, la viabilidad económica del sistema se desploma.

El otro gran problema es la radiación. Las GPU comerciales no están diseñadas para el espacio. La radiación cósmica y las erupciones solares pueden freír la electrónica. La solución es el blindaje, que añade peso y, por lo tanto, coste de lanzamiento. Por no hablar de que el mantenimiento no es posible con la tecnología actual.

Imagen | Starcloud

–

La noticia

A la IA se le está quedando corta la energía de este mundo. Así que Nvidia ha apostado por servidores en el espacio

fue publicada originalmente en

Xataka

por

Matías S. Zavia

.

El apetito energético de los centros de datos no es ninguna novedad. Elon Musk vaticina una escasez de transformadores en dos años. Sam Altman cree que necesitaremos una revolución energética, como la fusión nuclear, para mantener el ritmo. El planeta no estaba preparado para tanta demanda de energía. Y por eso Nvidia está financiando una posible solución: desplegar los servidores fuera de la Tierra.No es ciencia ficción. Es el modelo de negocio de varias startups que proponen construir los próximos hipercentros de datos en la órbita terrestre e incluso en la Luna. La idea, que hasta hace poco sonaba descabellada, está cobrando tracción impulsada principalmente por dos factores: la demanda insaciable de la IA y los lanzamientos a bajo coste que promete Starship.

En Xataka

Isaac Asimov predijo en 1941 los satélites que transmiten energía a la Tierra. Ahora su idea está cerca de ser realidad

Una de las empresas que lidera esta idea es Starcloud, respaldada por el programa NVIDIA Inception. Y va tan en serio que planea lanzar su primer satélite, el Starcloud-1, en noviembre. A bordo llevará la primera GPU para data centers lanzada al espacio: una NVIDIA H100.

Lo difícil vendrá después. Starcloud-1 es una unidad de prueba del tamaño de una nevera pequeña, pero el objetivo de la compañía es construir un monstruoso centro de datos orbital de cinco gigavatios. Sumando los paneles solares y el enorme radiador, mediría cuatro kilómetros de ancho. Su objetivo es el entrenamiento de grandes modelos de IA en órbita.

¿Por qué en el espacio? Como detallan en un extenso white paper, los modelos futuros como GPT-6 o Llama 5 podrían requerir clústeres de varios gigavatios, algo “simplemente imposible con la infraestructura energética actual” de la Tierra. En el espacio, no existe esa limitación.

Es más. Según los cálculos de Starcloud, los costes energéticos de los servidores son 10 veces menores en el espacio que en la Tierra. La propuesta de valor de los data centers espaciales se sostiene, precisamente sobre dos pilares que en la Tierra son un problema: la energía y la refrigeración.

Energía solar 24/7. En la Tierra, la energía solar es intermitente. Dependen del ciclo día/noche, el tiempo y la atmósfera, que atenúa la radiación. En el espacio, la cosa cambia. Al situar sus data centers en una órbita heliosíncrona de tipo “amanecer-anochecer”, los satélites siguen la línea que divide el día y la noche en la Tierra.

Con los paneles iluminados por el sol de forma casi continua, el sistema eleva su capacidad a más del 95%. “Energía renovable casi ilimitada y de bajo coste”, en palabras de Starcloud.

¿Y la refrigeración? ¿Cómo disiparían todo ese calor? Los data centers terrestres consumen millones de litros de agua dulce para enfriarse. En el espacio no hay agua, pero tienen algo mucho mejor: un disipador térmico infinito a -270°C.

El plan no es ventilar los servidores. El calor generado por las GPU (como la H100) se gestionará dentro de los módulos sellados mediante refrigeración líquida (directa al chip o por inmersión), como los sistemas de alto rendimiento en la Tierra. La diferencia es que ese líquido caliente no va a una torre de evaporación, sino que se bombea a unos paneles radiadores gigantescos.

Estos paneles simplemente irradian el calor residual al vacío del espacio en forma de radiación infrarroja. El white paper de Starcloud detalla los cálculos usando la ley de Stefan-Boltzmann, estimando que un radiador a 20°C puede disipar limpiamente más de 630 vatios por metro cuadrado. Sin usar una sola gota de agua.

No es oro todo lo que reluce en el espacio. El pilar que sostiene todo este concepto es el lanzamiento de cohetes reutilizables de gran capacidad, como el Starship de SpaceX. Los cálculos de Starcloud se basan en un coste a largo plazo de 30 dólares por kilo puesto en órbita. Pero Starship no está lista, y desde luego está lejos de lograr su capacidad de reutilización rápida y total. Si ese coste no se materializa, la viabilidad económica del sistema se desploma.

El otro gran problema es la radiación. Las GPU comerciales no están diseñadas para el espacio. La radiación cósmica y las erupciones solares pueden freír la electrónica. La solución es el blindaje, que añade peso y, por lo tanto, coste de lanzamiento. Por no hablar de que el mantenimiento no es posible con la tecnología actual.

Imagen | Starcloud

En Xataka | La energía solar espacial nunca funcionó. Una escalada militar en órbita está haciendo que se vuelva realidad

– La noticia

A la IA se le está quedando corta la energía de este mundo. Así que Nvidia ha apostado por servidores en el espacio

fue publicada originalmente en

Xataka

por

Matías S. Zavia

.