Ciencia y Tecnología

Este ingenioso test de Microsoft te reta a encontrar imágenes generadas con IA. La mayoría falla más de lo que imagina

Detectar imágenes o vídeos generados con inteligencia artificial es cada vez más complicado. Los pequeños errores que antes nos ponían en alerta —manos con dedos de más, reflejos incoherentes, texturas extrañas— empiezan a desaparecer. Y con ellos, también desaparecen nuestras certezas.

Pero ¿hasta qué punto estamos perdiendo esa capacidad de distinguir lo real de lo artificial? ¿Qué tan fácil es confundir una foto auténtica con una creada por IA? Un nuevo estudio del AI for Good Lab de Microsoft intenta responder a estas preguntas. Y lo hace con datos que invitan a reflexionar.

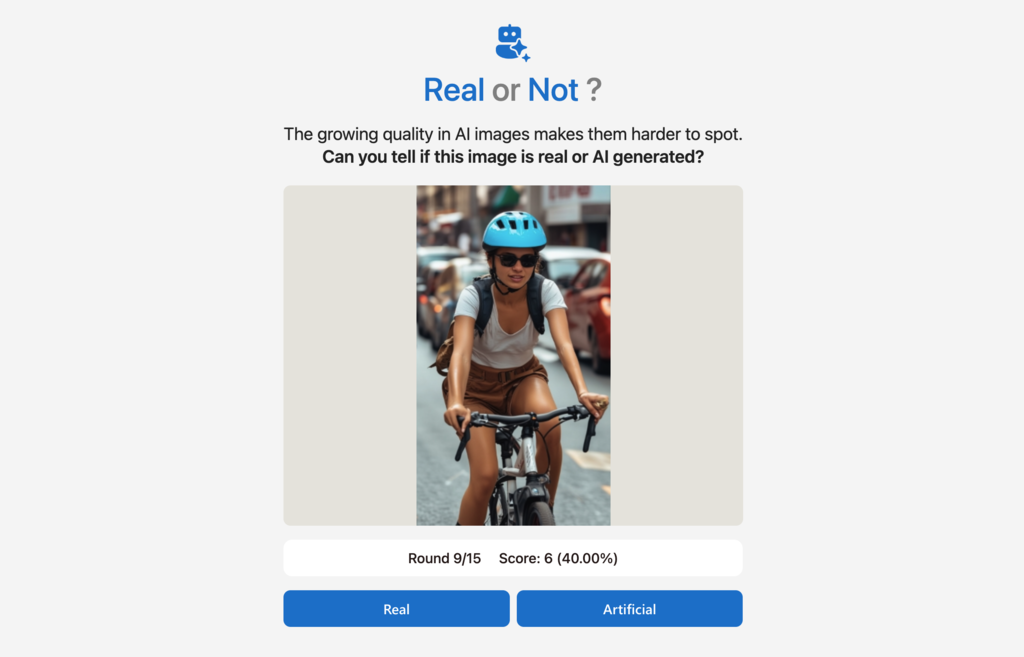

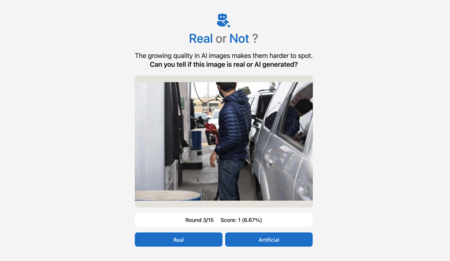

Más de 12.000 personas frente a la IA. Para medir con cifras concretas nuestra habilidad, Microsoft lanzó un experimento a gran escala basado en un sencillo juego en línea, Real or Not Quiz. El reto es directo: ver una imagen y decidir si es real o generada por IA.

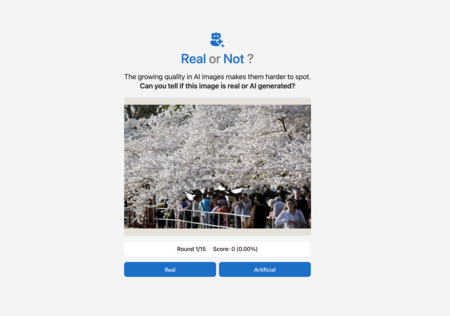

Entre el 1 y el 8 de agosto de 2024, los participantes completaron 17.340 partidas y evaluaron unos 287.000 fotogramas. El conjunto incluía 350 imágenes reales y aproximadamente 700 sintéticas, creadas con DALL-E 3, Midjourney v6, Amazon Titan v1, Stable Diffusion XL, Stable Diffusion-3, variantes de inpainting y rostros producidos con GANs.Los resultados no son alentadores: la tasa media de acierto fue del 62% y, aplicada solo a las imágenes generadas por IA, subió apenas al 63%.

Más llamativo aún: las imágenes que más confundieron a los jugadores no eran falsas, sino genuinas. Tres fotos reales obtuvieron menos de un 20% de aciertos, probablemente porque su estética —luces muy contrastadas o escenas inusuales— recuerda a lo que asociamos con la IA.

Rostros bien, paisajes mal. Al segmentar por temática, el patrón es claro: acertamos más cuando aparecen personas y fallamos estrepitosamente con paisajes naturales o urbanos. La explicación que dan los investigadores es doble. Por un lado, el cerebro humano está finamente entrenado para detectar imperfecciones en rostros; por otro, la exposición continua a imágenes de modelos como Midjourney o DALL-E nos ha enseñado a reconocer ciertos rasgos estilísticos. En cambio, los paisajes “corrientes” generados por motores menos populares —o por algoritmos ajustados a estética aficionada— se camuflan mejor.

Los parámetros técnicos no bastan. El equipo también midió rango dinámico, exposición o nitidez. Aunque se detectan pequeñas diferencias, son demasiado sutiles para que un usuario medio las perciba a simple vista. La intuición, por tanto, se queda corta.

Superados por los detectores automáticos. Microsoft comparó el rendimiento humano con su propio detector de imágenes IA, que supera el 95% de aciertos y mantiene esa precisión en cualquier categoría. El problema es que estas herramientas no siempre están disponibles y muchas imágenes carecen de marcas de agua o credenciales. Sin esa firma digital, seguimos dependiendo de nuestro juicio visual.

Ponte a prueba. Si quieres comprobar por ti mismo lo difícil que es distinguir una foto real de una creada por IA, el Real or Not Quiz sigue abierto al público. Quizá descubras que tu ojo crítico todavía tiene margen de mejora.

Imágenes | Microsoft

–

La noticia

Este ingenioso test de Microsoft te reta a encontrar imágenes generadas con IA. La mayoría falla más de lo que imagina

fue publicada originalmente en

Xataka

por

Javier Marquez

.

Detectar imágenes o vídeos generados con inteligencia artificial es cada vez más complicado. Los pequeños errores que antes nos ponían en alerta —manos con dedos de más, reflejos incoherentes, texturas extrañas— empiezan a desaparecer. Y con ellos, también desaparecen nuestras certezas.

Pero ¿hasta qué punto estamos perdiendo esa capacidad de distinguir lo real de lo artificial? ¿Qué tan fácil es confundir una foto auténtica con una creada por IA? Un nuevo estudio del AI for Good Lab de Microsoft intenta responder a estas preguntas. Y lo hace con datos que invitan a reflexionar.

Más de 12.000 personas frente a la IA. Para medir con cifras concretas nuestra habilidad, Microsoft lanzó un experimento a gran escala basado en un sencillo juego en línea, Real or Not Quiz. El reto es directo: ver una imagen y decidir si es real o generada por IA.

Entre el 1 y el 8 de agosto de 2024, los participantes completaron 17.340 partidas y evaluaron unos 287.000 fotogramas. El conjunto incluía 350 imágenes reales y aproximadamente 700 sintéticas, creadas con DALL-E 3, Midjourney v6, Amazon Titan v1, Stable Diffusion XL, Stable Diffusion-3, variantes de inpainting y rostros producidos con GANs.Los resultados no son alentadores: la tasa media de acierto fue del 62% y, aplicada solo a las imágenes generadas por IA, subió apenas al 63%.

Más llamativo aún: las imágenes que más confundieron a los jugadores no eran falsas, sino genuinas. Tres fotos reales obtuvieron menos de un 20% de aciertos, probablemente porque su estética —luces muy contrastadas o escenas inusuales— recuerda a lo que asociamos con la IA.

Rostros bien, paisajes mal. Al segmentar por temática, el patrón es claro: acertamos más cuando aparecen personas y fallamos estrepitosamente con paisajes naturales o urbanos. La explicación que dan los investigadores es doble. Por un lado, el cerebro humano está finamente entrenado para detectar imperfecciones en rostros; por otro, la exposición continua a imágenes de modelos como Midjourney o DALL-E nos ha enseñado a reconocer ciertos rasgos estilísticos. En cambio, los paisajes “corrientes” generados por motores menos populares —o por algoritmos ajustados a estética aficionada— se camuflan mejor.

Los parámetros técnicos no bastan. El equipo también midió rango dinámico, exposición o nitidez. Aunque se detectan pequeñas diferencias, son demasiado sutiles para que un usuario medio las perciba a simple vista. La intuición, por tanto, se queda corta.

Superados por los detectores automáticos. Microsoft comparó el rendimiento humano con su propio detector de imágenes IA, que supera el 95% de aciertos y mantiene esa precisión en cualquier categoría. El problema es que estas herramientas no siempre están disponibles y muchas imágenes carecen de marcas de agua o credenciales. Sin esa firma digital, seguimos dependiendo de nuestro juicio visual.

En Xataka

“Extraordinariamente ricos”: Jensen Huang tiene muy claro cómo debe pagar a sus empleados para que NVIDIA tenga éxito

Ponte a prueba. Si quieres comprobar por ti mismo lo difícil que es distinguir una foto real de una creada por IA, el Real or Not Quiz sigue abierto al público. Quizá descubras que tu ojo crítico todavía tiene margen de mejora.

Imágenes | Microsoft

En Xataka | Uno podría pensar que pagar 200 euros al mes por Claude permitiría usarlo sin límites. Anthropic opina lo contrario

– La noticia

Este ingenioso test de Microsoft te reta a encontrar imágenes generadas con IA. La mayoría falla más de lo que imagina

fue publicada originalmente en

Xataka

por

Javier Marquez

.