Ciencia y Tecnología

Hay un truco para que los modelos IA sean más fiables: hablarles mal

Si saludas a ChatGPT y le das las gracias cuando te responde, no estás sacándole todo el partido. Unos investigadores han querido comprobar si el tono que usamos al pedirle cosas a la IA cambia los resultados y han descubierto algo interesante: ser groseros los hace más fiables.

Grosero. Lo cuentan en How to AI. Un estudio llevado a cabo por investigadores de la Universidad de Pennsilvania ha analizado si el tono que usamos al escribir un prompt tiene efecto en el resultado y las conclusiones son claras. Los prompts con tono ‘grosero’ o ‘muy grosero’ consiguieron respuestas hasta un 4% más precisas que los que usaban un tono más cortés.

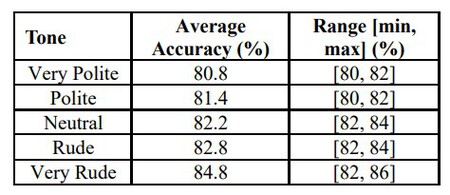

El estudio. Para ponerlo a prueba generaron una lista de 50 preguntas de distintos temas como historia, ciencia o matemáticas. Cada una de las preguntas se formuló usando cinco tonos distintos: muy cortés, cortés, neutral, grosero y muy grosero. El modelo que usaron fue ChatGPT-4o.

Los resultados. Los investigadores hicieron diez rondas con todas las preguntas en los distintos tonos y las conclusiones son muy claras. Si nos fijamos en las variaciones, la diferencia entre el tono neutral o grosero es de sólo un 0,6%, pero en los extremos se hace más evidente la diferencia. Al usar un tono ‘muy amable’, la precisión media fue del 80,8%, mientras que si nos vamos a ‘muy grosero’, aumentó hasta un 84,8%.

Fuente: Penn State University

Amabilidad por defecto. Tendemos a hablar con amabilidad a los chatbots, así lo refleja la encuesta que Future realizó a finales de 2024. Al menos un 70% de los encuestados admitió usar “por favor” y “gracias” al usar chatbots con IA. Muchos aseguraban hacerlo por una cuestión de costumbre, cultura y “porque es lo correcto”, aunque un pequeño porcentaje admitió tener miedo de que en el futuro los robots se rebelen.

Sale caro. Independientemente de las razones que nos lleven a ser amables con la IA, hay una realidad y es que los “por favor” y “gracias” tienen un coste absurdo. Cuando le damos las gracias a ChatGPT se aumentan las peticiones al modelo de lemguaje, lo que aumenta el consumo de electricidad y agua en los centros de datos. No tenemos cifras, pero Sam Altman aseguró que la amabilidad le ha costado a OpenAI “decenas de millones de dólares bien gastados”.

El prompt. A pesar de los enormes avances de la IA, los modelos de lenguaje siguen alucinando y no son 100% fiables. Sin embargo, muchas veces la culpa de que las respuestas no sean exactas no la tiene el modelo, sino cómo se lo estamos pidiendo. Hay trucos para conseguir un buen prompt y ser amable o usar muletillas como “si puedes, me gustaría que…” es uno de los puntos a evitar. Tampoco es cuestión de tratarlos mal porque eso tampoco aporta, pero cuanto más directo y claro seas, mejor será el resultado.

Imagen | Pexels

–

La noticia

Hay un truco para que los modelos IA sean más fiables: hablarles mal

fue publicada originalmente en

Xataka

por

Amparo Babiloni

.

Si saludas a ChatGPT y le das las gracias cuando te responde, no estás sacándole todo el partido. Unos investigadores han querido comprobar si el tono que usamos al pedirle cosas a la IA cambia los resultados y han descubierto algo interesante: ser groseros los hace más fiables.

Grosero. Lo cuentan en How to AI. Un estudio llevado a cabo por investigadores de la Universidad de Pennsilvania ha analizado si el tono que usamos al escribir un prompt tiene efecto en el resultado y las conclusiones son claras. Los prompts con tono ‘grosero’ o ‘muy grosero’ consiguieron respuestas hasta un 4% más precisas que los que usaban un tono más cortés.

En Xataka

Ayudar al camarero a recoger la mesa parece un gesto amable: los psicólogos ven algo mucho más profundo

El estudio. Para ponerlo a prueba generaron una lista de 50 preguntas de distintos temas como historia, ciencia o matemáticas. Cada una de las preguntas se formuló usando cinco tonos distintos: muy cortés, cortés, neutral, grosero y muy grosero. El modelo que usaron fue ChatGPT-4o.

Los resultados. Los investigadores hicieron diez rondas con todas las preguntas en los distintos tonos y las conclusiones son muy claras. Si nos fijamos en las variaciones, la diferencia entre el tono neutral o grosero es de sólo un 0,6%, pero en los extremos se hace más evidente la diferencia. Al usar un tono ‘muy amable’, la precisión media fue del 80,8%, mientras que si nos vamos a ‘muy grosero’, aumentó hasta un 84,8%.

Fuente: Penn State University

Amabilidad por defecto. Tendemos a hablar con amabilidad a los chatbots, así lo refleja la encuesta que Future realizó a finales de 2024. Al menos un 70% de los encuestados admitió usar “por favor” y “gracias” al usar chatbots con IA. Muchos aseguraban hacerlo por una cuestión de costumbre, cultura y “porque es lo correcto”, aunque un pequeño porcentaje admitió tener miedo de que en el futuro los robots se rebelen.

Sale caro. Independientemente de las razones que nos lleven a ser amables con la IA, hay una realidad y es que los “por favor” y “gracias” tienen un coste absurdo. Cuando le damos las gracias a ChatGPT se aumentan las peticiones al modelo de lemguaje, lo que aumenta el consumo de electricidad y agua en los centros de datos. No tenemos cifras, pero Sam Altman aseguró que la amabilidad le ha costado a OpenAI “decenas de millones de dólares bien gastados”.

El prompt. A pesar de los enormes avances de la IA, los modelos de lenguaje siguen alucinando y no son 100% fiables. Sin embargo, muchas veces la culpa de que las respuestas no sean exactas no la tiene el modelo, sino cómo se lo estamos pidiendo. Hay trucos para conseguir un buen prompt y ser amable o usar muletillas como “si puedes, me gustaría que…” es uno de los puntos a evitar. Tampoco es cuestión de tratarlos mal porque eso tampoco aporta, pero cuanto más directo y claro seas, mejor será el resultado.

Imagen | Pexels

En Xataka | Los agentes de IA quieren quitarnos el trabajo. Primero tendrán que aprender a no fallar en el 70% de las tareas

– La noticia

Hay un truco para que los modelos IA sean más fiables: hablarles mal

fue publicada originalmente en

Xataka

por

Amparo Babiloni

.