Ciencia y Tecnología

China ya no se conforma con alejarse de NVIDIA. Su siguiente paso es el corazón de la IA con un sistema que rompe moldes

En 2017, el paper “Attention Is All You Need” de Google cambió la base técnica de la generación de lenguaje: los Transformers permitieron procesar secuencias largas en paralelo y escalar modelos hasta tamaños que antes eran inviables. Esa ruta de escalado ha impulsado a arquitecturas como GPT y BERT y ha convertido la autoatención en la pieza central de la IA generativa contemporánea.

Pero este novedoso enfoque llegó acompañado de costes crecientes en memoria y energía cuando el contexto se alarga, una limitación que ha motivado investigaciones para desarrollar alternativas. SpikingBrain-1.0 apunta a romper moldes.

Del “Attention Is All You Need” al cerebro: la nueva apuesta para romper límites en IA

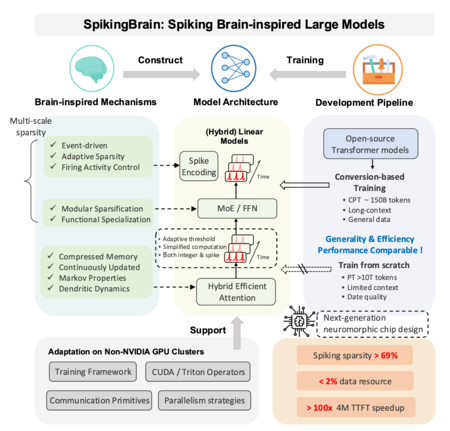

Un equipo del Instituto de Automatización de la Academia China de Ciencias acaba de presentar SpikingBrain-1.0. Estamos hablando de una familia de modelos espigados orientada a reducir datos y cómputo necesarios para tareas con contextos muy largos. Los expertos proponen dos enfoques: SpikingBrain-7B, de arquitectura lineal enfocada a eficiencia, y SpikingBrain-76B, que combina atención lineal con mecanismos Mixture of Experts (MoE) de mayor capacidad.

Los autores detallan que gran parte del desarrollo y las pruebas se llevaron a cabo en clústeres de GPU MetaX C550, con bibliotecas y operadores diseñados específicamente para esa plataforma. Esto convierte el proyecto no solo en un avance prometedor a nivel de software, sino también en una demostración de capacidades de hardware propio. Un aspecto especialmente relevante si se tiene en cuenta el esfuerzo de China por reducir su dependencia de NVIDIA, una estrategia que ya vimos reflejada con DeepSeek 3.1.

SpikingBrain-1.0 está inspirado directamente en cómo funciona nuestro cerebro. En vez de tener neuronas que siempre están “encendidas” calculando números, usa neuronas espigadas: unidades que van acumulando señales hasta que superan un umbral y disparan un pico (spike). Entre pico y pico no hacen nada, lo que ahorra operaciones y, en teoría, energía. La clave es que no solo importa cuántos picos hay, sino cuándo ocurren: el momento exacto y el orden de esos picos llevan información, como pasa en el cerebro.

Para que este diseño funcione con el ecosistema actual, el equipo desarrolló métodos que convierten los bloques de autoatención tradicionales en versiones lineales, más fáciles de integrar en su sistema espigado, y creó una especie de “tiempo virtual” que simula los procesos temporales sin frenar el rendimiento en GPU. Además, la versión SpikingBrain-76B incluye Mixture of Experts (MoE), un sistema que “despierta” solo a ciertos submodelos cuando hacen falta, que también hemos visto en GPT-4o y GPT-5.

Los autores sugieren aplicaciones donde la longitud de contexto es determinante: análisis de grandes expedientes jurídicos, historias clínicas completas, secuenciación de ADN y conjuntos masivos de datos experimentales en física de altas energías, entre otros. Ese encaje aparece razonado en el documento: si la arquitectura mantiene eficiencia en contextos de millones de tokens, reduciría costes y abriría posibilidades en dominios hoy limitados por el acceso a infraestructuras de cómputo muy caras. Pero queda pendiente la validación en entornos reales fuera del laboratorio.

El equipo ha liberado en GitHub el código de la versión de 7.000 millones de parámetros junto a un informe técnico detallado. También ofrece una interfaz web similar a ChatGPT para interactuar con el modelo, que según los autores está desplegado íntegramente en hardware nacional. El acceso, sin embargo, está limitado al chino, lo que complica su uso fuera de ese ecosistema. La propuesta es ambiciosa, pero su verdadero alcance dependerá de que la comunidad logre reproducir los resultados y realizar comparativas en entornos homogéneos que evalúen precisión, latencias y consumo energético en condiciones reales.

Imágenes | Xataka con Gemini 2.5 | aboodi vesakaran

En Xataka | OpenAI cree haber descubierto porqué las IAs alucinan: no saben decir “no lo sé”

–

La noticia

China ya no se conforma con alejarse de NVIDIA. Su siguiente paso es el corazón de la IA con un sistema que rompe moldes

fue publicada originalmente en

Xataka

por

Javier Marquez

.

En 2017, el paper “Attention Is All You Need” de Google cambió la base técnica de la generación de lenguaje: los Transformers permitieron procesar secuencias largas en paralelo y escalar modelos hasta tamaños que antes eran inviables. Esa ruta de escalado ha impulsado a arquitecturas como GPT y BERT y ha convertido la autoatención en la pieza central de la IA generativa contemporánea. Pero este novedoso enfoque llegó acompañado de costes crecientes en memoria y energía cuando el contexto se alarga, una limitación que ha motivado investigaciones para desarrollar alternativas. SpikingBrain-1.0 apunta a romper moldes.Del “Attention Is All You Need” al cerebro: la nueva apuesta para romper límites en IAUn equipo del Instituto de Automatización de la Academia China de Ciencias acaba de presentar SpikingBrain-1.0. Estamos hablando de una familia de modelos espigados orientada a reducir datos y cómputo necesarios para tareas con contextos muy largos. Los expertos proponen dos enfoques: SpikingBrain-7B, de arquitectura lineal enfocada a eficiencia, y SpikingBrain-76B, que combina atención lineal con mecanismos Mixture of Experts (MoE) de mayor capacidad.

Los autores detallan que gran parte del desarrollo y las pruebas se llevaron a cabo en clústeres de GPU MetaX C550, con bibliotecas y operadores diseñados específicamente para esa plataforma. Esto convierte el proyecto no solo en un avance prometedor a nivel de software, sino también en una demostración de capacidades de hardware propio. Un aspecto especialmente relevante si se tiene en cuenta el esfuerzo de China por reducir su dependencia de NVIDIA, una estrategia que ya vimos reflejada con DeepSeek 3.1.

SpikingBrain-1.0 está inspirado directamente en cómo funciona nuestro cerebro. En vez de tener neuronas que siempre están “encendidas” calculando números, usa neuronas espigadas: unidades que van acumulando señales hasta que superan un umbral y disparan un pico (spike). Entre pico y pico no hacen nada, lo que ahorra operaciones y, en teoría, energía. La clave es que no solo importa cuántos picos hay, sino cuándo ocurren: el momento exacto y el orden de esos picos llevan información, como pasa en el cerebro.Para que este diseño funcione con el ecosistema actual, el equipo desarrolló métodos que convierten los bloques de autoatención tradicionales en versiones lineales, más fáciles de integrar en su sistema espigado, y creó una especie de “tiempo virtual” que simula los procesos temporales sin frenar el rendimiento en GPU. Además, la versión SpikingBrain-76B incluye Mixture of Experts (MoE), un sistema que “despierta” solo a ciertos submodelos cuando hacen falta, que también hemos visto en GPT-4o y GPT-5.

Los autores sugieren aplicaciones donde la longitud de contexto es determinante: análisis de grandes expedientes jurídicos, historias clínicas completas, secuenciación de ADN y conjuntos masivos de datos experimentales en física de altas energías, entre otros. Ese encaje aparece razonado en el documento: si la arquitectura mantiene eficiencia en contextos de millones de tokens, reduciría costes y abriría posibilidades en dominios hoy limitados por el acceso a infraestructuras de cómputo muy caras. Pero queda pendiente la validación en entornos reales fuera del laboratorio.

En Xataka

La alianza ASML-Mistral desvela el plan B europeo: si no podemos fabricar chips, al menos controlaremos cómo se fabrican

El equipo ha liberado en GitHub el código de la versión de 7.000 millones de parámetros junto a un informe técnico detallado. También ofrece una interfaz web similar a ChatGPT para interactuar con el modelo, que según los autores está desplegado íntegramente en hardware nacional. El acceso, sin embargo, está limitado al chino, lo que complica su uso fuera de ese ecosistema. La propuesta es ambiciosa, pero su verdadero alcance dependerá de que la comunidad logre reproducir los resultados y realizar comparativas en entornos homogéneos que evalúen precisión, latencias y consumo energético en condiciones reales.Imágenes | Xataka con Gemini 2.5 | aboodi vesakaran En Xataka | OpenAI cree haber descubierto porqué las IAs alucinan: no saben decir “no lo sé”

– La noticia

China ya no se conforma con alejarse de NVIDIA. Su siguiente paso es el corazón de la IA con un sistema que rompe moldes

fue publicada originalmente en

Xataka

por

Javier Marquez

.